Peering erklärt: Warum schnelles Internet nicht immer schnell ist

Marius

Der Internetvertrag verspricht 300 Mbit/s, der Speedtest bestätigt die Geschwindigkeit, und trotzdem laden bestimmte Webseiten abends quälend langsam. Videos ruckeln, Downloads kriechen, und die eigentlich flotte Leitung fühlt sich manchmal an wie ein alter DSL-Anschluss aus den 2000ern. Der Router wurde schon dreimal neu gestartet, aber es wird einfach nicht besser. Häufig ist man dann ratlos, weil offensichtlich alles funktioniert und man nicht weiß, wo man überhaupt ansetzen soll. Doch das Problem liegt oft weder am Router noch am eigenen Anschluss. Es liegt an etwas, das sich Peering nennt und das die meisten Internetnutzer noch nie gehört haben, obwohl es maßgeblich darüber entscheidet, wie schnell das Internet tatsächlich funktioniert. Für Unternehmen, die auf Cloud-Dienste, Warenwirtschaftssysteme oder einen Remote-Arbeitsplatz setzen, hat das ganz konkrete Auswirkungen: Die Peering-Qualität Ihres Internet-Anbieters beeinflusst direkt, wie schnell und zuverlässig Ihre Cloud-Anwendungen laufen. Und nicht jeder Anbieter hält sich an den weltweiten Standard.

Was steckt hinter dem Begriff Peering?

Das Internet ist kein einzelnes Netz. Es besteht aus tausenden eigenständigen Netzwerken, die miteinander verbunden werden müssen, damit Daten von A nach B fließen können. Peering ist genau diese Verbindung: der Punkt, an dem zwei Netzwerke aufeinandertreffen und Daten austauschen.

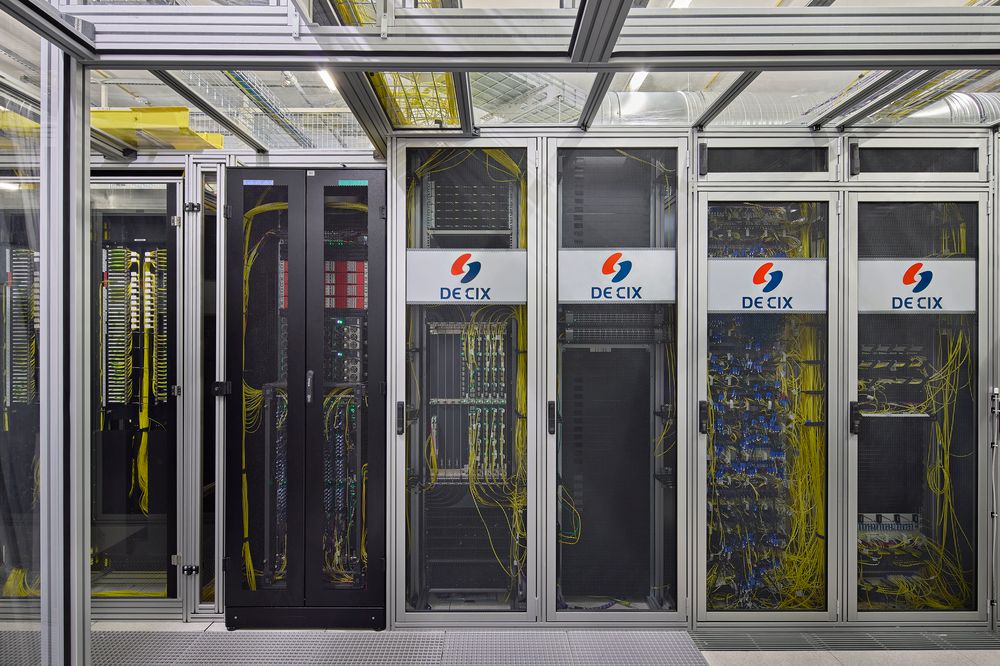

Stellen Sie es sich wie ein System aus Autobahnen vor. Verschiedene Betreiber bauen und betreiben jeweils ihre eigenen Strecken. Damit der Verkehr reibungslos fließt, braucht es Verbindungsstellen, an denen Fahrzeuge von einem System ins andere wechseln können. Im Internet heißen diese Verbindungsstellen Internet Exchange Points, kurz IXP. Ein Exchange Point ist im Grunde ein großer Netzwerk-Verteiler, an dem sich hunderte Provider und Diensteanbieter direkt miteinander verbinden können. Statt den Datenverkehr über Umwege zu schicken, wird er am Exchange Point auf dem kürzesten Weg übergeben.

Der weltweit größte Internet-Austauschknoten steht in Frankfurt am Main. Der DE-CIX verbindet knapp 1.100 Netzwerke und verzeichnete im Dezember 2025 einen Spitzendurchsatz von fast 27 Terabit pro Sekunde. Insgesamt wurden 2025 allein am Standort Frankfurt 48 Exabyte an Daten ausgetauscht. Zum Vergleich: Ein Exabyte entspricht einer Milliarde Gigabyte.

Der entscheidende Punkt ist: In den allermeisten Fällen tauschen Netzwerke ihre Daten abrechnungsfrei aus. Dieses Prinzip heißt Settlement-Free Peering und funktioniert, weil beide Seiten profitieren. Der Internet-Anbieter bekommt schnellere Verbindungen zu beliebten Diensten für seine Kunden. Der Diensteanbieter erreicht seine Nutzer auf kürzestem Weg. Nach Zahlen von Cloudflare, einem der weltweit größten Netzwerk- und Sicherheitsanbieter (der unter anderem rund 20 Prozent aller Webseiten weltweit ausliefert), werden 99,99 Prozent des gesamten Internet-Datenverkehrs abrechnungsfrei ausgetauscht. So funktioniert das Internet seit Jahrzehnten, und es funktioniert gut - normalerweise.

Warum die Telekom eine Ausnahme bildet

Die Deutsche Telekom geht als größter Internet-Anbieter Deutschlands einen anderen Weg. Sie verlangt von Diensteanbietern Geld für den direkten Datenaustausch. Wer nicht zahlt, kommt trotzdem ins Telekom-Netz, aber über Umwege: Die Daten werden über günstige Transit-Anbieter geroutet, statt direkt am Internetknoten übergeben zu werden. Diese Umwege führen vor allem in den Abendstunden zu Engpässen. Bei Cloudflare wurden bei Telekom-Kunden Paketverluste von über 14 Prozent dokumentiert. Zum Vergleich: Ab etwa einem Prozent Paketverlust wird Videotelefonie praktisch unbrauchbar.

Ein auffälliges Indiz: Nutzt man auf dem gleichen Anschluss ein VPN, das den Datenverkehr über einen anderen Anbieter leitet, funktioniert plötzlich alles einwandfrei. Das Problem liegt also nicht in der Leitung, sondern an der Verbindung zwischen Telekom und bestimmten Diensten.

Verbraucherschützer sehen darin eine Verletzung der Netzneutralität. Die Initiative netzbremse.de, getragen vom Verbraucherzentrale Bundesverband, der Gesellschaft für Freiheitsrechte und der Stanford-Professorin Barbara van Schewick, hat eine offizielle Beschwerde bei der Bundesnetzagentur angekündigt. Die Telekom argumentiert dagegen, dass große US-Konzerne rund 60 Prozent des Datenverkehrs verursachen und sich an den Kosten beteiligen sollten. Das Thema wird auf EU-Ebene unter dem Stichwort "Network Usage Fees" intensiv diskutiert. Die europäische Regulierungsbehörde BEREC hat sich bislang gegen solche Gebühren ausgesprochen und Cloudflare hat die Debatte in einer ausführlichen Analyse dokumentiert.

Für Unternehmen ist die Situation besonders brisant, denn der Trend geht in die falsche Richtung: Ende 2025 hat auch Vodafone angekündigt, sich vollständig von öffentlichen Internetknoten wie dem DE-CIX zurückzuziehen. Das gesamte Peering wird an den privaten Dienstleister Inter.link ausgelagert, über den Peering-Partner künftig Gebühren nach Datenvolumen zahlen müssen. Was das für die Verbindungsqualität bedeutet, wird sich zeigen, aber die Parallelen zur Telekom-Strategie sind offensichtlich. Wenn sich dieses Modell bei den großen Anbietern durchsetzt, hängt die Qualität Ihrer Internetverbindung in Zukunft nicht mehr nur von der gebuchten Bandbreite ab, sondern auch davon, welche kommerziellen Deals Ihr Internetanbieter mit den Diensten abgeschlossen hat, die Sie täglich nutzen. Wer Cloud-Software betreibt, ein Warenwirtschaftssystem in der Cloud nutzt oder auf Videokonferenzen angewiesen ist, sollte sich heute schon fragen, ob der eigene Internetanbieter hier zukunftssicher aufgestellt ist.

Für die Netzneutralität in Deutschland ist diese Entwicklung ein ernstes Problem. Wenn die beiden größten deutschen Internetanbieter den Weg des kostenpflichtigen Peerings einschlagen, entsteht eine Situation, in der wenige Konzerne kontrollieren, wie schnell welche Dienste bei Ihnen ankommen. Und wenn sich solche geschlossenen Modelle erst einmal etabliert haben, ist davon auszugehen, dass die Gebühren mittelfristig steigen werden. Deutschland hat mit dem DE-CIX in Frankfurt den größten Internet-Austauschknoten der Welt direkt vor der Haustür. Das ist ein enormer Standortvorteil, um den uns andere Länder beneiden. Offenes Peering am DE-CIX sorgt dafür, dass Daten auf kürzestem Weg und mit minimaler Verzögerung ausgetauscht werden. Dass ausgerechnet die großen deutschen Anbieter diesen Vorteil zugunsten eigener Einnahmen aufgeben, geht letztlich auf Kosten der Kunden.

Was das für Cloud-Dienste im Unternehmen bedeutet

Jede Verzögerung auf dem Weg zwischen Ihrem Büro und dem Rechenzentrum spüren Ihre Mitarbeiter. Eine Warenwirtschaft, die beim Aufrufen von Artikelstammdaten eine Gedenksekunde einlegt. Eine Videokonferenz, die in der entscheidenden Minute einfriert. Ein Cloud-Backup, das nachts nicht durchläuft. Die Ursache muss nicht Ihre Internetleitung sein, es kann das Peering Ihres Providers sein.

Große Cloud-Anbieter wie Microsoft investieren deshalb massiv in eigene Netzwerk-Infrastruktur. Microsofts globales Backbone-Netzwerk umfasst über 165.000 Meilen Glasfaser mit direktem Peering zu mehr als 4.000 Netzwerken. In Deutschland ist Microsoft direkt am DE-CIX angebunden. Das ist ein Grund, warum Cloud-Dienste, die auf dieser Infrastruktur laufen, oft weniger von Peering-Problemen einzelner Provider betroffen sind als kleinere Dienste, die auf das offene Internet angewiesen sind.

Cloud-Performance für Ihr Unternehmen

Sie möchten wissen, wie sich die Netzwerk-Qualität auf Ihre Cloud-Anwendungen auswirkt? In einer unverbindlichen Erstberatung analysieren wir Ihre Situation und zeigen Ihnen konkrete Möglichkeiten.

Besonders relevant ist das für Unternehmen, die auf einen Cloud-PC oder Remote-Arbeitsplatz setzen. Da beim Remote-Arbeitsplatz die eigentliche Rechenarbeit im Rechenzentrum stattfindet und lediglich das Bildschirmsignal zum Endgerät übertragen wird, sind die Anforderungen an die Bandbreite überraschend gering. Selbst eine Verbindung mit kleinen Engpässen reicht für flüssiges Arbeiten, weil nur wenige Kilobyte pro Sekunde für die Bildschirmübertragung anfallen. Nicht die vielen Megabyte, die beim klassischen Dateizugriff über VPN-Verbindungen durch die Leitung geschoben werden müssen. Wenn Ihre Branchensoftware direkt neben dem Datenbankserver im Rechenzentrum läuft, macht sich ein Peering-Engpass auf dem letzten Kilometer kaum bemerkbar.

Worauf es beim Internetanbieter wirklich ankommt

Die reine Download-Geschwindigkeit, mit der Internet-Anbieter gerne werben, sagt über die tatsächliche Qualität einer Verbindung erstaunlich wenig aus. Für Unternehmen, deren Geschäftsprozesse auf Cloud-Software laufen, sind andere Faktoren entscheidender.

Testen Sie Ihre Verbindung nicht nur mit einem allgemeinen Speedtest. Messen Sie gezielt die Latenz zu den Zielen, die für Ihr Unternehmen wichtig sind: zu Ihrem Cloud-Anbieter, zu den Rechenzentren Ihrer Branchensoftware, zu Microsoft 365. Und zwar nicht nur morgens um neun, sondern auch nachmittags und abends, wenn die Netze ausgelastet sind. Die Geschwindigkeit zum nächsten Speedtest-Server sagt wenig darüber aus, wie schnell Ihre Warenwirtschaft in der Cloud reagiert.

Regionale Internet-Anbieter und Stadtwerke mit eigener Glasfaserinfrastruktur sind in der Praxis oft eine gute Alternative zu den großen Netzbetreibern. Viele dieser Anbieter setzen auf offenes Peering am DE-CIX und haben damit exzellente Verbindungen zu allen großen Cloud-Diensten. Es lohnt sich, bei der nächsten Vertragsentscheidung gezielt nach der Peering-Strategie zu fragen.

Wer es ganz genau wissen will, findet auf peeringdb.com eine öffentliche Datenbank, in der Netzwerkbetreiber ihre Peering-Informationen hinterlegen: An welchen Internetknoten sie präsent sind, mit wem sie direkt verbunden sind und welche Kapazitäten sie bereitstellen. Die Datenbank richtet sich primär an Netzwerktechniker und ist nicht ganz einfach zu lesen, gibt aber einen ehrlichen Einblick, wie gut ein Anbieter tatsächlich vernetzt ist.

Und wenn Sie ohnehin über eine Modernisierung Ihrer IT-Infrastruktur nachdenken: Cloud-Architekturen, bei denen die Verarbeitung im Rechenzentrum stattfindet, sind von Peering-Engpässen deutlich weniger betroffen als Lösungen, bei denen große Datenmengen zwischen Büro und Cloud pendeln müssen. Das ist ein Aspekt, der bei der Kalkulation der IT-Kosten gerne übersehen wird.

Wenn Sie unsicher sind, wie gut Ihre Anbindung zu den Cloud-Diensten ist, die Sie nutzen, oder ob Ihre IT-Architektur optimal aufgestellt ist, sprechen Sie uns gerne an. Wir helfen Ihnen bei der Einschätzung und zeigen Ihnen, welche Möglichkeiten es gibt, Ihre IT-Infrastruktur zukunftssicher aufzustellen.